Este 2025 comenzó con un cambio en la industria tecnológica: la llegada de Muse, en asociación con Microsoft, y el debut de ACE con Nvidia y Xbox; dos AIs generativas capaces de construir entornos virtuales interactivos en videojuegos. Con este anuncio, la inteligencia artificial pasó de la simple generación de imágenes y videos—que ya había mostrado señales de agotamiento creativo—a sumergirse por completo en la creación de mundos completos, con sus propias reglas y paisajes en constante transformación. Y aquí llega la pregunta inevitable:

¿Cómo suenan estos nuevos mundos virtuales generativos?

Desde la industria tecnológica nos están entrenando no solo para habitar entornos virtuales cada vez más similares a la realidad, sino también para entender cómo se crean.

Estas nuevas tecnologías edifican paisajes virtuales moldeando nuestra relación con el entorno inmediato, y en ese proceso, nos obligan a repensar el papel que comienzan a jugar los diseñadores de experiencias inmmersivas.

La arquitectura invisible.

El sonido siempre fue una arquitectura invisible, un idioma que habla directo al cuerpo. La reverberación de un túnel subterráneo nos dice más sobre su profundidad que cualquier render en 4K.

El crujir de la grava bajo los pies, la densidad de la niebla en una calle vacía, incluso el vacío del silencio artificial: todos estos son elementos tradicionalmente diseñados por manos humanas, con decisiones humanas. Pero, ¿qué sucede cuando estos paisajes comienzan a generarse por sí mismos? ¿Cuando el sonido deja de ser compuesto y comienza a ser predicho?

Una reverberación nos indica la profundidad de un túnel antes de verlo; la direccionalidad de un sonido nos hace girar la cabeza en una habitación oscura.

Si el sonido siempre nos ha conectado con el espacio de forma intuitiva, la tecnología ahora redefine esa relación.

Hace algunos años, grabé un programa de radio dentro de la Torre de Agua Sur en Alemania (Wasserturm Süd en Halle, Saale).

La torre era un cilindro inmenso, vacío, una cáscara de concreto y ladrillo. Esa experiencia marcó mi entendimiento de las reverberaciones. En un espacio circular de gran altura, una voz, un bandoneón y un clarinete transforman un espacio vacío y semiabandonado en un lugar lleno de vida.

Me pregunto qué pasará cuando la acústica de un espacio deje de ser una consecuencia física y se convierta en una decisión algorítmica.

Cuando una IA determine la duración exacta de una reverberación o la profundidad sonora de un túnel antes de que alguien lo atraviese, ¿seguiremos percibiendo el espacio de la misma manera? ¿O nos adaptaremos a una arquitectura sonora que ya no responde a nuestra presencia, sino a una lógica calculada acerca de cómo suena un espacio?

El Futuro Suena a Datos

Pero la industria del videojuego no solo observa este avance con entusiasmo, sino también con preocupación. WHAM (World and Human Action Model) como se llama a la tecnología que impulsa Muse, ya está demostrando que la predicción y la generación de entornos en tiempo real son la nueva frontera.

Con solo un segundo de juego humano—equivalente a diez fotogramas—es capaz de predecir la evolución de una sesión de videojuego.

Si Muse crea mundos y WHAM los anticipa, es solo cuestión de tiempo antes de que sistemas similares también se encarguen de la organización del sonido en el espacio.

La IA no solo podrá generar sonidos en tiempo real, sino decidir dónde ubicarlos, cómo se comportan en relación al entorno y cuál será su interacción con el usuario.

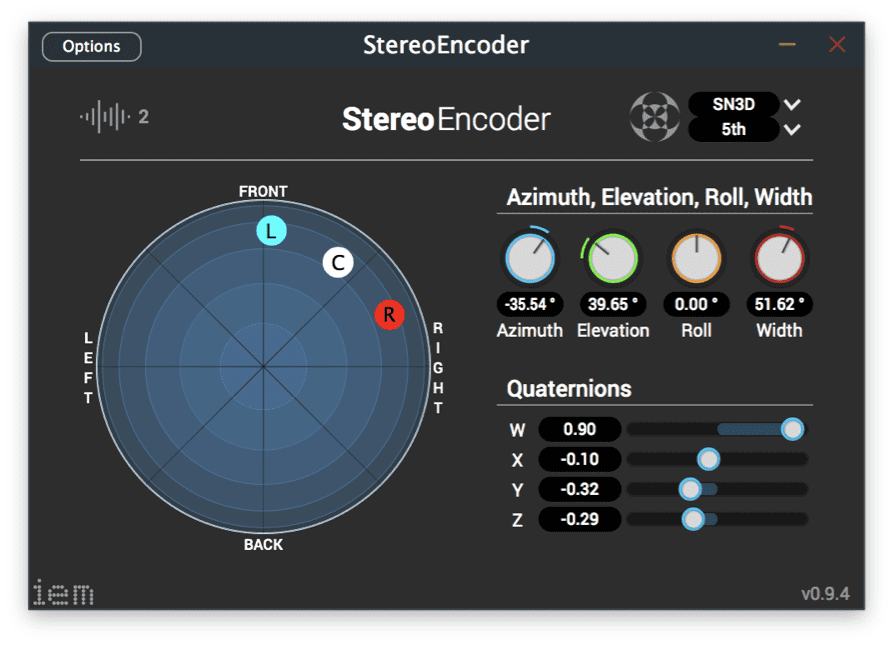

La evolución tecnológica de la espacialización de audio, desde la estereofonía hasta el audio basado en objetos, ha transformado la forma en que experimentamos el sonido en un espacio; pero la inteligencia artificial podría llevarlo un paso más allá: un espacio sonoro que se adapta constantemente a la posición del usuario, su velocidad, el entorno visual e incluso su estado emocional.

Ya no hablaremos de diseñadores de sonido programando cada efecto manualmente, sino de sistemas entrenados para generar entornos sonoros completos.

Pero no se trata solo de crear sonidos; se trata de definir las reglas por las cuales se distribuirán en el espacio virtual.

Si la IA aprende a generar entornos sonoros, la pregunta es: ¿qué datos utilizará para entrenarse?. Si solo se alimenta de paisajes sonoros convencionales, podría acabar replicando un mundo estático, carente de la diversidad y la organicidad del sonido real. La IA no improvisa ni sueña; solo replica lo que le damos.

Si entrenamos a un sistema con grabaciones de espacios urbanos que reflejan únicamente las culturas hegemónicas, estos podrían acabar siendo un eco artificial de las grandes potencias y la representación pobre de las regiones más marginadas.

Si la base de datos proviene exclusivamente de grabaciones cinematográficas o bancos de sonidos que ya están en internet, perderemos la riqueza del sonido espontáneo y natural.

La forma en que curemos estos datasets determinará el tipo de paisajes que se construirán en el futuro.

Pero ¿Quiénes serán los próximos curadores de estos bancos de datos? ¿Cómo nos preparamos para estos nuevos modelos en los que el arte se ve condicionado por la IA? ¿Los usuarios se darán realmente cuenta de la diferencia?

La industria de los videojuegos ya se ha dividido en dos posturas claras. Por un lado, están quienes ven a las nuevas IA generativas como una herramienta tecnológica que agiliza y perfecciona la creación de mundos, como Brendan Greene, responsable de popularizar el género battle royale, del cual surgieron juegos como Fortnite.

Por otro lado, están quienes consideran que la IA reemplazará a los trabajadores de la industria con modelos carentes de creatividad y que los jugadores notarán este cambio. En este grupo se encuentran los creadores del sello No GEN AI, un colectivo de desarrolladores independientes que ha diseñado un logo para que los estudios puedan mostrarlo en las páginas de las tiendas digitales, indicando que en la creación del videojuego no se utilizó ninguna IA generativa.

El Gran Desafío: Entre la Creación y la Curaduría

La pregunta es: ¿seguiremos diseñando sonidos o empezaremos a curar datos sonoros para la IA?

Desde mi punto de vista el diseñador de sonido del futuro ya no compondrá una atmósfera desde cero, sino que seleccionará, depurará y modelará datasets de millones de sonidos, entrenando así a un sistema que creará sonidos en tiempo real.

Como un arqueólogo digital, no crearán tanto como dirigirán las posibilidades de la máquina. Su tarea será elegir los sonidos, definir sus características y establecer los parámetros con los cuales la IA operará dentro de un entorno inmersivo.

Si el rol del diseñador de sonido se inclina cada vez más hacia la gestión de datos y el entrenamiento de modelos, nuestra manera de percibir el espacio cambiará por completo.

No se trata solo de adaptar, sino de decidir si queremos que el sonido del futuro sea una mera réplica de lo que ya conocemos o una oportunidad para reimaginar nuestra relación con la escucha, tanto en espacios virtuales como físicos.

No estoy en contra de la inteligencia artificial, pero tampoco la veo como una solución absoluta. Creo que es esencial comprender sus implicaciones, explorar sus posibilidades y cuestionar sus límites.

Las respuestas a estas preguntas quizás nos den la posibilidad de encontrar huecos posibles en un sistema que determinará la forma en la que concebimos la realidad inmediata.